“Beware of bugs in the above code; I have only proved it correct, not tried it.”

– Donald Knuth[1]Siehe Anmerkungen unter http://www-cs-faculty.stanford.edu/~knuth/faq.html.

Nach der ersten Recherche (siehe Abschnitt 3.7.1) werden bei Langzeitbewahrungsprojekten fast ausschließlich bereits existierende Emulatoren bevorzugt bzw. verwendet. Es hat sich dabei gezeigt, dass sowohl Designentscheidungen als auch die Auswahl von Emulatoren größtenteils aus pragmatischen (Realisierbarkeit bestimmter Detailgrade vs. Aufwand) und ökonomischen (zur Verfügung stehende Ressourcen) Gesichtspunkten getroffen werden. In diesem Kapitel werden daher mögliche Abweichungen sowie Entstehungsfaktoren qualifiziert benannt und untersucht.

Eine systematische Aufstellung und Kategorisierung soll es ermöglichen, den ökonomischen Aufwand zu beziffern, Beschränkungen des jeweiligen Bewahrungsprojektes zu identifizieren und (technische) Anforderungen an Emulatoren der Zukunft zu stellen. In diesem Zusammenhang stellt sich die Frage nach der angestrebten Authentizität einer Emulationslösung und wie sich diese klassifizieren lässt. Rothenberg versucht dies in Experimenten mit der Koninklijke Bibliotheek der Niederlande durch die Aufstellung von fünf allgemeinen Anforderungsgraden gegenüber dem Originalobjekt: “same for all intents and purposes”, “same functionality and relationships to other publications”, “same ‘look-and-feel’”, “same content (for any definition of the term)” sowie “same description”.[3]Rothenberg, J.: An Experiment in Using Emulation to Preserve Digital Publications. Den Haag: Koninklijke Bibliotheek (NEDLIB Report Series), 2000, S. 72.

„Same for all intents and purposes“ stellt den höchsten Anforderungsgrad dar und bedingt eine faktische Gleichheit mit dem Originalobjekt. Rothenberg sieht hier die Herausforderung in der Entwicklung von “[…] specification techniques that can describe all relevant attributes of hardware computing platforms in sufficient detail to allow them to be emulated on future platforms”.[4]ebenda, S. 83. Vergleicht man dies mit den Anforderungen an die korrekte Reproduktion und Aufführung von Computerspielen (auch im Hinblick auf ihre Dualität als Kunstobjekt und kommerzielle Ware), ist nur dieser höchste Anforderungsgrad geeignet, das Wesen komplexer dynamischer Objekte wie Computerspiele zu erhalten. Die anderen Grade reichen für die vollständige Erhaltung von Computerspielen nicht aus. Bewahrungsziele, Faktoren und Abweichungen müssen daher immer gegenüber diesem Höchstmaß an Authentizität gemessen bzw. beschrieben werden. Andersherum kann man der Authentizität eines Objekts anhand der entstehenden Lücke zwischen angestrebtem und tatsächlich realisiertem bzw. realisierbaren Detailgrad beschreiben.

Hierzu wird der Begriff der Translation Gap eingeführt, der als Maß für die Authentizität der Reproduktion eines dynamischen Objektes den Grad bzw. die Anzahl der Abweichungen beschreibt. Mithilfe der so entstehenden Skala sollen im Folgenden Abweichungen quantifiziert und entscheidende Faktoren erfasst werden.

4.1 Definition Translation Gap

In der Sprachwissenschaft wird mit dem Begriff Translation Gap die semantische Lücke bei der Übersetzung von Texten einer natürlichen Sprache in eine andere bezeichnet. Diese entsteht beispielsweise durch Spracheigentümlichkeiten oder Redewendungen für die es keine (exakte) Entsprechung in der Zielsprache gibt. Vielmehr müssen zur Übersetzung sinngleiche, semantisch ähnliche Konzepte in der Zielsprache gefunden sowie in den jeweiligen kulturellen Kontext des Rezipientenkreises eingebettet werden. Bei historischen Texten ist zudem die Anpassung von nicht mehr gebräuchlichen Idiomen notwendig.

In Anlehnung an dieses Konzept werden in diesem Werk mit Translation Gap alle Abweichungen bezeichnet, die bei der Rezeption eines komplexen digitalen Artefakts innerhalb einer Emulationsumgebung sowie bei der Interaktion mit der Emulationsumgebung gegenüber der Rezeption und Interaktion mit der Originalumgebung des Artefakts bestehen. Dabei ist zwischen Abweichungen auf physischer, logischer und konzeptueller Ebene des Objektes (siehe Abschnitt 2.2) zu unterscheiden und eine prinzipielle Unterteilung der Entstehungsfaktoren vorzunehmen.

Komponenten und Ebenen

In Kapitel 3 wurde auf die technische Dimension des Emulationskonzeptes fokussiert. Es konnten bisher Abweichungen auf der konzeptuellen Objektebene aufgrund technischer Ungenauigkeiten des gewählten Abstraktionsgrads des Emulators auf der nachgeahmten physischen Ebene identifiziert werden. Dieser technische Faktor hatte Einfluss auf die Interaktionserfahrung, wobei die Auswirkungen auf inhaltlicher Ebene jedoch nicht allgemein abschätzbar waren. So können eine Vielzahl Artefakte – von kaum merkbaren visuellen Abweichungen oder Unterschieden in der Ablaufgeschwindigkeit – bis hin zum vollständigen Verlust der Reproduzierbarkeit einer Klasse von Objekten auftreten. Der Abweichungsgrad kann für diese Fälle jedoch immer nur mittels Vergleichstests für das konkrete Objekt bestimmt werden. Es wurde zudem gezeigt, dass neben technischen auch pragmatische bzw. ökonomische Abwägungen Einfluss auf die Implementierung hatten.

Von Interesse ist zudem, dass ein Emulator in der Literatur entweder als bereits gegeben oder als von externen Dienstleistern zu entwickeln angesehen wird. Hierbei kommt es zu einer impliziten Kompetenzverschiebung der Entscheidungsgewalt über die Objekterhaltung von Gedächtnisorganisationen hin zu technischen Dienstleistern bzw. Softwareentwicklern. Die an der Entwicklung von Emulatoren beteiligten Personenkreise scheinen also eine weitere wichtige Komponente in der Entstehung und Beurteilung von Abweichungen zu sein. Es ist zu klären, welche Gruppen unter welchen Bedingungen Emulatoren entwickeln, um Gründe für getroffene Designentscheidungen und deren Auswirkungen nachvollziehen zu können.

Um weitere Komponenten und Entstehungsfaktoren für Abweichungen zu finden, müssen die grundlegenden Merkmale des Untersuchungsgegenstands Computerspiele bzw. komplexe dynamische Objekte betrachtet werden. Erste Anhaltspunkte können sich aus dem Wesen des Mediums Computerspiel selbst, dessen Benutzungsarten und dessen dualen Charakters als Kunstobjekt und kommerziellen Massenprodukt ergeben. Für interaktive Objekte (insbesondere Spiele) scheint es notwendig, den Geltungsbereich der Rezeptionsumgebung – bestehend aus Software-, Hardware- und Interaktionskomponenten – zu erfassen und ihre intrinsischen Eigenschaften zu berücksichtigen.

Die höchsten Anforderungskriterien sind dabei im Bereich der digitalen elektronischen Kunst zu finden. Howard Besser beschreibt in [Besser 2001a] Problemfelder der Langzeitbewahrung elektronischer Kunst, die aufgrund der speziellen Eigenschaften des Kunstobjekts entstehen. Neben den auch für konventionelle digitale Objekte geltenden Problemen der rapiden Obsoleszenz von Dateiformaten sowie der Datenträgeralterung (vom Autor viewing problem genannt[5]vgl. Besser, H.: Digital Preservation of Moving Image Material. In: The Moving Image – Journal of the Association of Moving Image Archivists, Volume 1, Issue 1, 2001, S. 264., identifiziert Besser zudem ein inter-relational problem und ein translation problem. Das inter-relational problem beschreibt die Verbindungen zwischen digitalen Objekten z.B. bei rekontextualisierender Webkunst. In Seiten eingebettete Inhalte wie Video oder Hyperlinks können mit der Zeit ungültig werden, Server abgeschaltet oder Inhalte verändert oder gelöscht werden. Dies verändert die Gesamtkomposition und Interaktion mit dem Objekt.[6]vgl. ebenda, S. 265.

Das translation problem beschreibt Veränderungen in der Bedeutung (meaning) bzw. im Sinngehalt des Kunstwerks durch Migration der Ein- und Ausgabeschnittstellen der Rezeptionsumgebung in eine andere Form. So wurde unter anderem eine Vielzahl früher elektronischer Kunst auf CRT-Röhrenmonitoren oder Fernsehern gezeigt. Würden diese bei einem Defekt durch aktuelle Flachbildschirme (LCD, TFT, o.Ä.) vorgeführt, so würde das Werk dadurch verändert, da Flachbildschirme andere Ausgabecharakteristika (Farbe, Helligkeit, Bildwiederholfrequenz, Auflösung usw.) als Röhrenbildschirme besitzen.[7]vgl. ebenda, S. 266. Traditionell ist jedoch die Ausstellung eines elektronischen Kunstwerks mit dem Medium eng verbunden, auf dem es der Künstler erstellt hat. Eine Veränderung wird daher häufig als eine Verschlechterung der Reproduktion angesehen. So verbot u.a. Gary Hill – einer der Pioniere der Videokunst – explizit der Tate Gallery of Modern Art, bei seinen Werken CRTs durch LCDs zu ersetzen.[8]vgl. ebenda.

Die Migration von Schnittstellen und Änderungen der Rezeptionsumgebung stellen eine weitere Komponente für Abweichungen auf der konzeptuellen Ebene des Objektes dar. Besser nennt Jaron Lanier als weiteres Beispiel. Dieser sah die Emulation eines seiner Spiele, welche auf neuerer Hardware schneller ablief, nicht mehr als sein Originalspiel an.[9]vgl. ebenda, S. 267f. sowie Abschnitt 3.5.1. Für Besser ist es daher essenziell, formale Aspekte des Werkes und seiner Umgebung (Aspekt-Ratio, Geschwindigkeit, Formate, etc.) in Zusammenarbeit mit dem Künstler festzuhalten.

Zuletzt muss auch der Charakter des Emulators und dessen Einbettung in die Emulation als Bewahrungsstrategie berücksichtigt werden. Zum einen ist der Emulator selbst ein komplexes dynamisches Objekt, das für künftige Rechnergenerationen bewahrt werden muss. Dieser rekursive Bewahrungsprozess muss auf mögliche Abweichungen bei der Reproduktion sowie prinzipbedingte Grenzen untersucht werden. Auch ist zu beachten, dass bei der Emulationsstrategie der erste Bewahrungsschritt der Transfer der digitalen Objektes vom Originalmedium und die Umwandlung in ein für den Emulator geeignetes logisches Format (Datenträgerabbilder, sogenannte Images) durchzuführen ist. Da Computerspiele durch technische Maßnahmen wie DRM oder Kopierschütze gesichert sein können, kann es bei diesem Prozess zu Abweichungen auf technischer Ebene kommen.

Zusammengefasst konnten die Interaktion mit der Emulationsumgebung, die Migration von Ein- und Ausgabeschnittstellen (siehe Abschnitt 4.2), das personelle Entstehungsumfeld des Emulators, betroffene Entwicklergruppen und deren Agenda (siehe Abschnitt 4.3) sowie im Kontext der Bewahrungsstrategie der Datenträgertransfer und die Erstellung, Bewahrung und der Charakter des Emulators selbst (siehe Abschnitte 4.4 und 5.3) als Entstehungsfaktoren für Abweichungen identifiziert werden.

Diese sollen im Folgenden untersucht, klassifiziert und die Ergebnisse anschließend systematisiert aufgestellt werden. Abweichungen können dabei Auswirkungen auf den Objektebenen physisch, logisch, konzeptuell und das Zusammenspiel aus Software, Hardware und Umgebung haben. Die Gründe können prinzipbedingt oder technischer, pragmatischer und ökonomischer Natur sein. Abschließend sind Auswirkungen und Gründe nach ihrem Grad von vernachlässigbar, semantischer Abweichung, Änderung der Interaktion, Verlust der Interaktion bis hin zum Verlust der Reproduzierbarkeit des Objektes zu beurteilen. Bei der Frage nach der Authentizität muss zwischen dem was prinzipiell, sinnvoll, und was teilweise erhalten werden kann unterschieden werden.

4.2 Translationsprobleme der Schnittstellenmigration

Das von Besser angesprochene Problem der Schnittstellenmigration beinhaltet zwei Aspekte. Einerseits besteht dasselbe Problem der Wahl des Authentizitäts- bzw. Abstraktionsgrads zur Modellierung der Schnittstelle des Emulators wie schon beim CPU-Modul demonstriert (siehe Abschnitt 3.6). Andererseits entsteht ein Translationsproblem beim Übergang der Daten von einer bzw. in eine sinnlich wahrnehmbare Form mithilfe der Ein- und Ausgabehardware. Da die Interaktion mit dem dynamischen Objekt nur über die analogen Eigenschaften der Schnittstellen stattfindet, verändert jede Änderung dieser Eigenschaften die Art, wie das Objekt rezipiert wird. Bei der Emulation obsoleter Hardwaresysteme müssen Schnittstellen jedoch zwangsweise durch kontemporäre Versionen (wie am Beispiel des Übergangs vom Röhren- zum Flachbildschirm) oder durch auf dem Hostsystem vorhandene Alternativen (z.B. PC-Tastatur anstelle eines Spielkonsolen-Joysticks) ersetzt werden.

Abstraktionsgrad der Schnittstellenemulation

Der erste Aspekt umfasst dabei die Anbindung der Schnittstellen an das Rechnersystem durch Hardwarecontroller. Am Beispiel der Grafikausgabe wären dies die Chips der Grafikkarte, nicht jedoch der Monitor bzw. die Darstellung auf Selbigem. Hier muss – wie in Abschnitt 3.5.3 beschrieben – bei der Implementierung des entsprechenden I/O-Subsystems der entsprechende Abstraktionsgrad festgelegt werden. Ist die Schnittstelle komplex, d. h. stellt sie selbst eine von-Neumann-Architektur mit Prozessor, Speicher, etc. dar (z. B. bei Grafikkartenprozessoren, Netzwerkkarten, System-on-a-Chip), dann muss zur vollständigen Repräsentation ein eigener Emulatorkern entwickelt werden, wodurch sich die Komplexität des Gesamtsystems deutlich erhöht. Zudem stellen Hardwarecontroller dem System eine eigene Abstraktionsebene zur Verfügung, da sie die interne Schnittstellenlogik, Eigenarten der spezifischen Hardware sowie deren Komplexität vom Computersystem verbergen und den Zugriff auf die Hardwarekomponente transparent über eine genormte Schnittstelle zur Verfügung stellen. So stellen beispielsweise die Festplatteninterfaces (S)ATA oder SCSI eine solche Abstraktionsebene dar, während die dahinter liegenden physischen und physikalische Gegebenheiten der Festplatte, wie extra Bereiche für defekte Sektoren, Anpassung der Drehgeschwindigkeit durch wärmebedingte Ausdehnung der Magnetscheibe oder interne Fehlerkorrekturmechanismen, verborgen werden.[10]Anderson, D.: You Don’t Know Jack about Disks. In: ACM Queue, Volume 1, Issue 4, 2003, S. 20–30. Nicht immer sind diese Informationen durch den Hersteller offengelegt. Es muss also wieder eine Auswahl nach pragmatischen Gesichtspunkten zwischen Implementierbarkeit, vorhandener Dokumentation und benötigter Systemgeschwindigkeit getroffen werden.

Dieser Aspekt findet ausführliche Betrachtung in [Phillips 2010].[11]Phillips, G.: Simplicity betrayed. In: Communications of the ACM, Volume 53, Issue 6, 2010, S. 52–58. Der Autor beschreibt darin das Verhältnis zwischen Genauigkeit der Implementierung von I/O-Subsystemen und deren Abbildung auf der Hardware des Hostsystems am Beispiel des Heimcomputers TRS-80. Im Text werden erste Hinweise zum Implementierungsaufwand einer möglichst originalgetreuen Nachbildung anhand eines selbst entwickelten Emulators gegeben. Phillips zieht dazu die Analogie zur Arbeit mit einer Programmierschnittstelle (API) aus der Softwareentwicklung. Ein Emulator kann zwar die Vorgänge einer CPU emulieren, simuliert aber lediglich die Ein-/Ausgabe-Hardwarekomponenten und reicht die Anfragen an diese übersetzt an das Hostsystem weiter. Der Emulator stellt dadurch Programmierschnittstellen in Form von simulierten Hardwareschnittstellen zur Verfügung, welche mit den Programmierschnittstellen der Hardware des Hostsystems in Deckung gebracht werden müssen.[12]vgl. ebenda, S. 52.

Das TRS-80-System verfügt über einen Textmodus mit 16 Zeilen und 64 Spalten. Die Ausgabe erfolgt auf einem Fernsehbildschirm. Neben dem ASCII-Zeichensatz bietet das System zudem einen Satz aus grafischen Sonderzeichen an, mit denen jede mögliche aus 2 × 3 Pixeln bestehende binäre Blockkombination darstellbar ist. Insgesamt ergibt sich somit eine Auflösung von 128 Pixeln horizontal und 48 Pixeln vertikal. Der Bildschirmspeicher wird dabei in den Hauptspeicher des Systems abgebildet, auf den Programme des Rechners direkt zugreifen können. Jedes Byte entspricht einem auf dem Bildschirm dargestellten Zeichen.[13]vgl. ebenda. Phillips entwickelt zunächst ein auf der Spezifikation des Systems basierendes einfaches API-Modell zur Erfassung der Grafikausgabe. Ein Update des Bildschirminhalts erfolgt alle 1/60 Sekunden.[14]Dies entspricht der Bildwiederholfrequenz von 60 Hz amerikanischer TV-Geräte mit NTSC-Norm. Der Emulator muss dazu den Bildschirmspeicher auslesen, das entsprechende Bild auf den Zeichen des Originalsystems rendern und auf dem Bildschirm des Hostsystems darstellen[15]vgl. ebenda, S. 53.. Dieses Verfahren funktioniert laut Phillips für die Mehrheit der untersuchten Programme. Die Ausgabe auf dem Emulator ist hinreichend ähnlich zu der auf der Hardware des Originalsystems. Der Autor bemerkte jedoch eine Abweichung bei einem seiner Testprogramme. Soll der Bildschirminhalt von komplett schwarz nach komplett weiß gefüllt werden, so dauern die entsprechenden Schreibzugriffe auf den Bildschirmspeicher länger als 1/60 Sekunden. Deshalb entsteht kurzzeitig ein Zwischenbild, auf dem der Bildschirm nur zur Hälfte gefüllt ist.

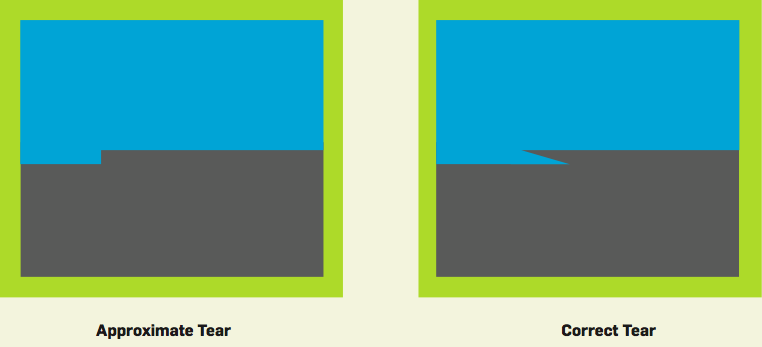

Beim nächsten 1/60 Intervall ist der Bildschirm dann komplett weiß gefüllt. Jedoch unterscheidet sich die Darstellung dieses Zwischenbildes im Emulator von der auf dem Originalsystem. Der Übergang zwischen schwarzen und weißen Pixeln ist im Emulator rechteckig, beim Originalsystem jedoch ein Dreieck.[16]vgl. ebenda, S. 54. Ein Vergleich der Darstellung des Zwischenbildes im Emulator und auf dem Originalsystem ist in Abbildung 4.1 zu sehen.

Abb. 4.1: Unterschiedliche Darstellung der Reißkante während des Bildaufbaus im Emulator (links) und der Originalhardware (rechts) bei Phillips[17]Phillips, G.: Simplicity betrayed. In: Communications of the ACM, Volume 53, Issue 6, 2010, Figure 2, S. 54.

Sowohl der Fetch-Execute-Zyklus, als auch das I/O-Subsystem für die Grafikausgabe mussten unter erheblichem Aufwand entsprechend angepasst werden. Phillips bemerkt, dass “[a] rather small test case required a considerable change in the program”[20]ebenda, S. 55. Phillips entwickelte daraufhin weitere Testszenarien, um Abweichungen insbesondere bei der Pixeldarstellung zu finden. Die entwickelten Testprogramme verhielten sich allerdings auf dem Originalsystem nicht so wie erwartet. Die Zeitverhältnisse entsprachen nicht den errechneten. Der Fehler konnte durch den Autor nur durch Zuhilfenahme des Hardwareschaltplans des Originalsystems gefunden werden. Eine Recherche ergab, dass aufgrund der CPU-Clock nicht wie erwartet 60 Bilder pro Sekunde, sondern nur 59.185 Bilder gezeichnet werden – mit drastischen Auswirkungen bei der Darstellung komplexer Animationen[21]vgl. ebenda. Der Emulator musste erneut angepasst und die API der simulierten Grafikhardware präzisiert werden.

Phillips führte weitere Iterationen mit spezifischen Testszenarien durch und stellte bei jeder weitere gravierende Abweichungen zwischen der Spezifikation des Emulators und dem Originalsystem fest. Beispielsweise verursachte eine Zeitverschiebung des Synchronisationsinterrupts um nur einen CPU-Zyklus einen Verlust der Bildschirmsynchronisation.[22]vgl. ebenda, S. 57. Auch verursachte die Sperrung des Grafikspeichers durch die CPU bei Zugriffen über die CPU unter bestimmten Bedingungen zu „Löchern“ in der Darstellung auf dem Originalsystem.[23]vgl. ebenda, S. 58.

Die Tests und Erweiterung bzw. Re-Implementierung des Grafik-Subsystems stellten sich – trotz der auf den ersten Blick Grafikfähigkeiten des TRS-80 – als extrem aufwendig heraus. Für Phillips sind sie zur originalgetreuen Darstellung von dynamischen Objekten jedoch unerlässlich, da selbst kleinste Abweichungen der Spezifikation die Interaktion mit dem Objekt deutlich verändern: “The result is not tiny differences only of interest to experts but extremely visible differences in program behavior between precise and sloppy emulators”.[24]ebenda.

Auch zeigt sich, dass Tests dieser Komplexität nur manuell durch einen Menschen durchgeführt werden können bzw. sogar zwingend müssen. Dies widerlegt Rothenbergs frühe Vermutung, das Emulatoren mittels automatisierter Softwaretests auf Kompatibilität zum Originalsystem geprüft werden können. Dem liegt die Annahme zugrunde, dass allein das erfolgreiche Durchlaufen (Starten) der Originalsoftware unter dem Emulator eine Kompatibilität zum Originalsystem begründet.[25]vgl. Rothenberg, J.: Avoiding Technological Quicksand – A Report to the Council on Library and Information Resources. 1999, S. 22 [abgerufen 24.04.2008] Im Lichte von Phillips Experimenten muss diese Annahme jedoch deutlich relativiert und automatisierte Tests als nicht ausreichend angesehen werden.

Migration der Ein- und Ausgabehardware

Der zweite Aspekt der Abbildung der simulierten Hardware auf die vorhandenen Hardwarekomponenten des Hostsystems scheint sich hingegen einer Softwarelösung gänzlich zu entziehen. Der Emulator emuliert das obsolete Originalsystem und transformiert dabei die Ein- und Ausgabeschnittstellen des Originalsystems auf die (ebenfalls abstrahierten) Schnittstellen des Hostsystems. Die jeweiligen I/O-Submodule führen also eine „Just-In-Time-Migration“ der Schnittstellen aus. Wie bei jeder Migration (siehe Abschnitt 2.4.3) können hier Abweichungen und Verluste durch Inkompatibilitäten bzw. fehlende Funktionalität auftreten, je nachdem, wie stark sich die Hardware des Original- und Hostsystems voneinander unterscheiden und welche Möglichkeiten sie bietet. Auf die physischen Eigenschaften der Ein-/Ausgabehardware hat der Emulator jedoch prinzipbedingt keinen Einfluss.

Tijms fasst dieses Dilemma unter dem Begriff outside environment (Außenumgebung bzw. Rezeptionsumgebung) zusammen: “One point even a complete system emulator does not address is the characteristics of the environment outside of the digital system”[26]Tijms, A.: Binary translation: Classification of emulators. Leiden Institute for Advanced Computer Science, Universität Leiden, 2000, S. 8. Für Tijms sind dies in erster Linie die audiovisuellen Signale, die der Nutzer wahrnimmt. Die intrinsischen – und für die Interaktion mit dem Objekt zu beachtenden – Eigenschaften der Rezeptionsumgebung bzw. Hardware sind dabei schwer zu definieren. Tijms nennt sowohl die spezifischen Eigenschaften von Röhrenmonitoren wie die Auflösung, Bewegungsunschärfe oder das Nachleuchten der Phosphore als auch die unterschiedliche Klangerzeugung durch verschiedene Audio-Synthesizer in Soundkarten als Beispiele, die auch bei einem Emulator mit Datenbus-Genauigkeit (siehe Abschnitt 3.6.4) außerhalb des Abbildungsraums liegen. Insbesondere bei Computerspielen der 80er- und 90er-Jahre wurden jedoch oft insbesondere diese Eigenschaften von Röhrenbildschirmen und Audiochips ausgenutzt, um bestimmte Spielobjekte und -artefakte zu erzeugen. Der Transfer auf einen Monitor mit deutlich höherer Auflösung führt zu einer starken „Verpixelung“ der Grafik des Originalsystems, sodass Artefakte verzerrt erscheinen und unter Umständen bestimmte Spielobjekte gar nicht mehr zu identifizieren sind.[27]vgl. ebenda. Das Ziel des Emulators, ein Höchstmaß an Authentizität zu erreichen, wird durch diesen Umstand ebenfalls verfehlt. “In this particular case the emulator would be useless […]”[28]ebenda. ist das vernichtende Fazit von Tijms, falls die Design-Maxime der authentischen Nachbildung der audiovisuellen Signale des Systems (und damit des Spielerlebnisses) nicht erreicht werden kann.

Phillips hat diesen Aspekt ebenfalls in die Betrachtung der Abweichungen seines TRS-80-Emulators gegenüber dem Originalsystem einfließen lassen. Zentral für seine Untersuchung waren die Eigenschaften des Fernsehbildschirms. Pixel auf Röhrenbildschirmen bestehen aus weichen Ovalen, bedingt durch die Phosphore auf der Frontscheibe und sehen damit gänzlich anders aus, als die eckigen Pixel moderner LCD-Flachbildschirme. Die Pixel eines Fernsehschirms sind zudem nicht distinkt, sondern überlappen in ihrer Ausleuchtung ein wenig. Darüber hinaus sind sie auch nicht unabhängig voneinander, sondern erscheinen unterschiedlich, je nach Anzahl der in einer Reihe aufleuchtenden Pixel. Der erste Pixel einer Zeile erstrahlt bedingt durch die Charakteristik des Elektronenstrahls heller.[29]Phillips, G.: Simplicity betrayed. In: Communications of the ACM, Volume 53, Issue 6, 2010, S. 57.

Alle diese subtilen Unterschiede summieren sich zu einem deutlich abweichenden Bild mit sichtbaren visuellen Artefakten, welche von einigen grafischen Programmen des Systems ausgenutzt wurden. Zwar hat ein Emulator keinen Einfluss auf die physischen Eigenschaften des Hostsystems, dennoch schlägt Phillips für sein Beispiel eine Teillösung vor. Der Emulator kann sich den o.g. Eigenschaften des TV-Bildschirms durch komplexe Grafikberechnungen annähern und somit das Verhalten und Aussehen der Pixel nachahmen. Dies erfordert jedoch noch einmal deutlich mehr Rechenzeit, um das über 30 Jahre alte System nachzubilden. Der Autor warnt, dass selbst die Rechenleistung aktueller Systeme nicht ausreichend sein kann, alle Facetten älterer Computersysteme in einem ausreichenden Detailgrad nachzubilden.[]vgl. ebenda.[/ref]

Systematische Aufstellung der Rezeptionsumgebung

Es ist notwendig, sich dieser Problematik systematisch zu nähern, um das Spannungsfeld zwischen Schnittstellenabweichungen und nicht (sinnvoll) migrier- bzw. konvertierbarer Sensorik zu ergründen. Phillips vertritt die These, dass die Hardware eines Originalsystems nur vollständig im Zusammenhang anhand ihrer Verwendung durch das Korpus von existierender Software für das System beschrieben werden kann.[30]vgl. ebenda, S. 52. Emulatoren für die Langzeitbewahrung sind von ihrem Bestimmungszweck rückwärtsgerichtet: Es soll eine abgeschlossene Menge existierender Software erhalten werden. Der Blick ist also nicht auf die Entwicklung und das Testen neu zu erstellende Software gerichtet. In diesem Kontext ist es sinnvoll, den Vorschlag von Phillips aufzugreifen und die für die authentische Nachbildung und Interaktion mit dem Objekt erforderlichen Eigenschaften eines Hardwaresystems sowie seiner Umgebung anhand der konkreten Anforderungen der zu erhaltenden Software zu betrachten.

Die enge Anbindung des digitalen Objektes an die analogen Komponenten bildet einen wichtigen Teil der Interaktion mit dem Objekt. Die zu bewahrende Rezeptionsumgebung umfasst daher alle Komponenten, die zur authentischen Interaktion mit dem dynamischen Objekt notwendig sind. Dazu können neben den Hardware-Systemkomponenten auch die Beschaffenheit des Systems selbst, dessen Standort, die Aufführungspraxis sowie alle weiteren analogen Objekte, die in die Interaktion einfließen, gehören.

Durch das in der Literatur diskutierte technische Schichtenmodell der Emulation (siehe Abschnitt 3.4.1 und Abb. 3.1) bleiben (durch die Beschränkung auf die „digitale Welt“) diese zentralen relevanten Merkmale jedoch vollständig unberücksichtigt. Das Modell muss entsprechend – insbesondere für den Bereich Spiele und Computerkunst – um eine „Schicht“ bestehend aus Rezeptionsumgebung und Aufführungspraxis ergänzt werden.

Besonders bei Computerspielen wurden die vielfältigen Möglichkeiten der Verknüpfung von analogen Artefakten mit dem digitalen Spielverlauf einerseits intensiv genutzt, um das immersive Erlebnis zu steigern (siehe Abschnitt 4.2), aber gleichzeitig auch, um Rechtsgüter vor unberechtigter Vervielfältigung zu schützen. Zu den bekanntesten Beispielen zählt die von Ralf Baer erfundene Spielkonsole Odyssey. Dieses 1972 von der Firma Magnavox verkaufte System gilt als erste kommerziell vertriebene Videospielkonsole und bot die Möglichkeit, vom Spielablauf sich unterscheidende Spiele wie Tennis, Skifahren, Hockey oder Autorennen auf dem TV-Bildschirm zu spielen.[31]vgl. u.a. Loebel, J.-M.: Erhaltung virtueller Realitäten. Restauration eines Virtual-Reality-Simulators für das Computerspielemuseum Berlin – ein Projektbericht. In: Sieck, J. (Hrsg.): Kultur … Continue reading Die Hardware der Konsole selbst war jedoch nur in der Lage, einige wenige weiße Quadrate und Striche auf dem Bildschirm zu erzeugen. Die eigentliche Differenzierung des Spiels entstand durch transparente farbige Plastikfolien, die vom Nutzer als Auflage auf dem Bildschirm angebracht werden mussten (siehe Abbildung 4.2). Die Auflagen erzeugten den Spielkontext und stellten somit eine vitale Erweiterung der Ausgabeschnittstelle des Systems dar. Um die sinnvolle Interaktion mit dem System zu erhalten, muss ein Emulator diese Folien ebenfalls reproduzieren und dynamisch über die eigentliche Grafikausgabe des Systems projizieren bzw. in diese einbetten – obwohl die Folien nicht Teil der Hard- und Softwarespezifikation des Systems im eigentlichen Sinne sind.

Abb. 4.2: Auswahl der angebotenen Bildschirmfolien für die entsprechenden Spiele der Odyssey-Konsole[32] Quelle: Winter, D.: Pong-Story. Magnavox Odyssey, First home video game console. Website, 2010, Bild-URL: http://www.pong-story.com/pics/odyssey/overlay.jpg [abgerufen 11.10.2012]

Es handelt sich hierbei um eine ungewöhnliche Form eines Kopierschutzes durch die Verknüpfung mit physischen Objekten. Die zugrundeliegende Idee jedoch wurde insbesondere in den 1980er- und 1990er-Jahren von Spieleherstellern mittels sogenannter „Handbuchabfragen“ verfolgt. Oft musste zu Beginn des Spiels ein vom Spiel zufällig ausgewähltes Wort auf einer bestimmten Zeile und Seite des Handbuches durch den Nutzer eingegeben werden. Wurde diese Abfrage falsch beantwortet, startete das Spiel nicht. Das Computerspiel Wasteland lagerte sogar für den Spielverlauf wichtige Teile der Handlung in das Handbuch aus, sodass das Spiel ohne Selbiges nicht benutzbar war. Frühe Abenteuerspiele der Firma Lucasfilm Games (später Lucas Arts) wie u. a. The Secret of Monkey Island oder Indiana Jones and the Fate of Atlantis benutzten dem Spiel beigelegte Coderäder als Kopierschutzabfrage.[33]Es handelte sich hierbei um gegeneinander verdrehbare Pappräder (ähnlich einer Parkscheibe) auf denen verschiedene Kombinationen von Codewörtern oder -symbolen angebracht waren. Der Nutzer wurde zu Beginn des Spiels aufgefordert, eine bestimmte Kombination auf seinem Coderad einzustellen und das abgelesene Ergebnis einzugeben. Die digitale Bewahrung der Software allein reicht in diesen ebenfalls Fällen nicht aus, die Interaktion mit dem Spiel zu erhalten.

Neben dieser direkten Verknüpfung spielen wie gezeigt die physischen Eigenschaften der Ein-/Ausgabehardware bei der Interaktion mit dem Spiel eine zentrale Rolle. Guttenbrunner et al. versuchen sich der Problematik systematisch durch eine gewichtete Ontologie essenzieller Hardware-Elemente von Konsolenspielen zu nähern. Die Autoren erstellen einen kategorisierten nach Ein- und Ausgabemedium sortierten Anforderungsbaum der Hardwarekomponenten. Die Autoren kommen zu dem Schluss, dass die Gewichtung ebenfalls nur anhand konkreter Hardware und Spiele erstellt werden.[34]vgl. Guttenbrunner, M.; et al.: Keeping the Game Alive: Evaluating Strategies for the Preservation of Console Video Games. In: International Journal of Digital Curation, Volume 1, Issue 5, … Continue reading kann. Durch die unüberschaubar große Anzahl verschiedener Systeme und Schnittstellen kann eine Betrachtung nicht abstrakt erfolgen. Eine abschließende Klassifizierung ist aufgrund der ständigen Weiterentwicklung von Hardware nicht möglich und auch nicht zielführend. Im Vordergrund muss vielmehr die Fallbetrachtung der konkreten Softwaresammlung stehen. Erste Hinweise für Langzeitbewahrungsprojekte können der TOTEM-Datenbank (siehe Abschnitt 3.2.3) entnommen werden.

Im Folgenden sollen daher exemplarisch gängige Hardwarekomponenten der in Abschnitt 3.7 aufgestellten Klassifizierung von historischen Computersystemen im Zusammenhang mit bestehenden Emulatoren (siehe Abschnitt 3.7.1) untersucht und – falls vorhanden – Beispiellösungsansätze, welche die Translation Gap minimieren, vorgestellt werden. Als übergeordnete Kategorien konnten bei den bisherigen Betrachtungen die Bildschirmausgabe (Übergang vom Röhren- zum Flachbildschirm), die Tonausgabe (Verwendung unterschiedlicher Audiosynthesizer), verschiedene Eingabegeräte (Interaktion mit dem Spiel), eventuelle Netzwerkkonnektivität und weitere Peripherie identifiziert werden. Die festgestellten Abweichungen werden anschließend auf ihre Auswirkungen auf die Interaktion mit der Rezeptionsumgebung und eine eventuelle veränderte Immersion des Spielers untersucht.

4.2.1 Bildschirmausgabe

Die visuelle Ausgabe des dynamischen Objekts auf einem Fernseher oder Bildschirm bildet den bilanzmäßig größten Anteil an der Rezeption des Objekts. Während die ersten Rechnersysteme aufgrund der begrenzten Speicherkapazität noch Vektorbildschirme (direkte Steuerung des Kathodenstrahls) benutzten, hat sich allgemein der Rasterbildschirm als dominante Technologie durchgesetzt. Bei Rasterbildschirmen wird der Bildschirminhalt in ein Punktraster unterteilt – die sogenannten Pixel. Für Heimcomputer und Spielkonsolen wird dabei traditionell der Fernseher als Ausgabegerät benutzt, da er in fast jedem Haushalt direkt zur Verfügung steht. Demgegenüber stehen Monitore mit deutlich höherer Auflösung, wie sie für PCs verwendet werden. Die Bildschirmtechnologie hat sich dabei in den letzten Jahren vom Röhrenschirm hin zu Flachbildgeräten (LCDs, Liquid Crystal Displays) weiterentwickelt.

Neben der Auflösung ist insbesondere für mobile Plattformen ein Trend zu höheren Pixeldichten zu beobachten. Bei PC-Monitoren liegt diese typischerweise bei 72 PPI (Pixels per Inch, engl. für Pixel pro Zoll). Bei Apple iPads mit „Retina“-Display beträgt diese hingegen 264 PPI.[35]Siehe Produktspezifikation unter http://support.apple.com/kb/SP662. Auflösung, Pixeldichte, Seitenverhältnis und physische Bildschirmgröße bilden zentrale Merkmale der Bildschirmausgabe.

Darüber hinaus sind die spezifischen Eigenschaften von Fernsehgeräten, insbesondere älteren Geräte mit Kathodenstrahlröhre für Systeme von Belang, die den Fernseher als primäres Ausgabemedium nutzten. Wie im Bereich der Videokunst (siehe Abschnitt 4.1) besteht eine starke Verbundenheit zwischen Spielkonsole bzw. Heimcomputer und Fernsehbildschirm.[36]vgl. detaillierte Fallstudien am Beispiel des Atari 2600 bei Montfort, N.; Bogost, I.: Racing the Beam: The Atari Video Computer System (Platform Studies). Cambridge: MIT Press, 2009.

In einem Vergleichstest der Systeme C64 und Atari 2600 von Huth zeigten sich deutliche Unterschiede zwischen der Darstellung auf dem Originalsystem und der im Emulator. Huth verwendete für das Hostsystem einen PC-Monitor mit 800 × 600 Pixel Auflösung. Als besonders problematisch erwiesen sich Unterschiede in der Farbdarstellung, dem Kontrast, der Helligkeit und Bildschärfe des Monitors im Gegensatz zum Fernseher.[37]vgl. Huth, K.: Probleme und Lösungsansätze zur Archivierung von Computerprogrammen – am Beispiel der Software des ATARI VCS 2600 und des C64. Diplomarbeit, HU Berlin, 2004, S. 111. Dem PC-Monitor fehlten die typischen Artefakte des Fernsehbildschirms, was zu einer „besseren“ Darstellung führte. Aus den Übertragungsstandards PAL und NTSC für Fernsehprogramme resultieren Einschränkungen für die Farbdarstellung und den Bildaufbau. Das verwendete 4:2:2-YUV-Farbmodell enthält beispielsweise nicht für jeden Pixel eine vollständige Farbinformation in jedem Kanal. Der Bildaufbau erfolgt durch zwei – jeweils zeilenversetzte – Halbbilder. In Verbindung mit den physischen Eigenschaften von Röhrenbildschirmen wie dem Nachleuchten der Phosphore bei Ansteuerung durch den Elektronenstrahl, entstehen in der Bildschirmdarstellung des rechnerisch erzeugten Bildes lassen Artefakte, welche teilweise von Programmieren des Originalsystems für graphische Effekte oder Spielmechaniken ausgenutzt wurden. Bei Rezeption auf LCD-Monitoren gehen diese Darstellungsartefakte verloren. Es kommt zu Abweichungen auf konzeptueller Ebene des Spiels.

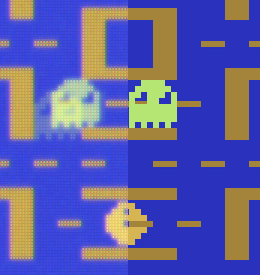

Bogost fasst die Fernsehdarstellung zusammen.[38]Bogost, I.: A TELEVISION SIMULATOR – CRT Emulation for the Atari VCS. In: Ian Bogost – Videogame Theory, Criticism, Design, Website, 2012. Er identifiziert dabei die spezifische Textur (texture) des Fernsehers mit Bewegungsunschärfe, Nachbilder auf der Netzhaut des Betrachters (afterimage), das Farbbluten (color bleed) sowie Bildrauschen (noise) und Bildaufbau aus Halbbildern (scan lines). Die Hintergrundtextur von Röhrenmonitoren ergibt sich aus dem Hintergrundleuchten, welches entsteht, wenn der Elektronenstrahl auf das Fokusgitter hinter den Phosphoren trifft. Nachbilder entstehen durch die Wechselwirkungen mit der Netzhaut im Auge des Menschen und dem Licht, das vom Bildschirm auf die Netzhaut auftrifft. Insbesondere diese Eigenschaft wurde benutzt, um Spieleffekte zu erzeugen: “Atari programmers took advantage of this feature to ‘flicker’ objects between frames”[39]ebenda.. Das charakteristische „Farbbluten“ von Röhrenbildschirmen bzw. -fernsehern entsteht durch Helligkeitsüberstrahlungen zwischen benachbarten Pixeln, was einerseits zur Weichzeichnung harter Kanten (Übergang zwischen farbigen und schwarzen Pixeln) und andererseits zu Farbmischungen zwischen den Phosphoren benachbarter Pixel führte. Hinzu kommt ein Bildrauschen durch die Konvertierung und Übertragung und Modulierung des Ausgabesignals auf Fernsehnormen.[40]vgl. ebenda.

Abb. 4.3 berechnete Noise-, Scan-Line-, After-Image- und Color-Bleed-Filtereffekte des Spiels Pac-Man im Atari-Emulator (linke Hälfte) gegenüber der Darstellung ohne Skeuomorphismen (rechte Hälfte)[41]Quelle: Bogost, I.: A TELEVISION SIMULATOR – CRT Emulation for the Atari VCS. In: Ian Bogost – Videogame Theory, Criticism, Design, Website, 2012, vergrößerter Bildausschnitt der Bild-URL: … Continue reading

Eine Simulation der Artefakte durch einen Emulator ist also möglich. Es muss allerdings auch hier wegen der aufwendigen Berechnungen eine Abwägung zwischen Emulationsgenauigkeit und Ausführungsgeschwindigkeit durchgeführt werden. Weitere Berechnungen können notwendig sein, um unterschiedliche Pixelgrößen und -verhältnisse (quadratische vs. rechteckige Pixel) auszugleichen.[43]Phillips, G.: Simplicity betrayed. In: Communications of the ACM, Volume 53, Issue 6, 2010, S. 52–58. Darüber hinaus kann es sinnvoll sein, Merkmale der Ausgabehardware im Zusammenhang mit der Rezeptionsumgebung zu erhalten. So ahmt beispielsweise der Cathode Terminal Emulator für MacOS X die Bildschirmwölbung, Verzerrungen und Spiegelungen eines Röhrenbildschirms nach.[44]Siehe Website des Herstellers unter http://www.secretgeometry.com/apps/cathode/.

Darüber hinaus muss der Emulator die deutlich geringere Grafikauflösung älterer Systeme auf die Auflösung aktueller Systeme transformieren, damit die Grafikausgabe auf dem Hostsystem ebenfalls bildschirmfüllend erfolgen kann.[45]Diese Problematik besteht bereits bei digitalen bzw. digitalisierten Filmaufnahmen. Eine Einführung bietet Besser, H.: Digital Preservation of Moving Image Material. In: The Moving Image – … Continue reading So beträgt die Auflösung des TRS-80 beispielsweise (siehe Abschnitt 4.1) mit 128 × 48 Pixeln nur 0,29 Prozent der Auflösung des aktuellen Apple iMacs (1920 × 1080 Pixel).

Zur Skalierung auf heutige Bildschirmauflösungen kommen verschiedene Filteralgorithmen zum Einsatz. Sie basieren auf der Fouriertransformation und konvertieren die Abtastrate des Bildes, welches anschließend über Rekonstruktionsfilter an die Zielauflösung angepasst wird. Bei der Interpolation von Rastergrafiken entstehen Qualitätsverluste, es kommt zu einer „Verpixelung“ des Bildes durch die Vergrößerung des Rasters. Um diese Effekte zu minimieren benutzen die Rekonstruktionsfilter bestimmte Techniken bei der Anpassung in das Zielraster, mit direktem Einfluss auf die optische Anmutung des Ergebnisses. Häufig verwendete Rekonstruktionsfilter sind die einfach Pixelwiederholung (nearest neighbour) sowie die bilineare und bikubische Interpolation. Bei der Erhöhung der Auflösung handelt es sich um eine gewollte Funktionsveränderung durch den Emulator (siehe Abschnitt 3.3). Die durch die Skalierung erzeugten Artefakte und somit veränderte optische Anmutung der Pixelgrafik werden in Kauf genommen, da die Darstellung in Originalauflösung zu einer erheblich kleineren Repräsentation des Objektes auf aktuellen Bildschirmen führen würde. Die Immersion in das Spielgeschehen würde durch die Verkleinerung der physischen Bildgröße erheblich beeinflusst. Eine Skalierung mittels Rekonstruktionsfiltern wird dementsprechend – wenn notwendig – von allen in Tabelle 1 gelisteten Emulatoren in unterschiedlichen Abstufungen unterstützt.[46]Teilweise sind solche Rekonstruktionsfilter auch als optionale Bibliotheken für bestehende Emulatoren verfügbar z. B. beim „Emulator Enhancer“ von Richard Bannister (verfügbar unter … Continue reading

4.2.2 Tonausgabe

Charakteristisch für den polyphonen Klang von 8-bit-Heimcomputern war der MOS 6581 Soundchip SID (Sound Interface Device). Er wurde unter anderem im Commodore C64 verbaut, der als meist verkaufter Heimcomputer aller Zeiten gilt.[47]Schätzungen gehen von ca. 30 Millionen verkaufter Geräte aus. Vgl. Bagnall, B.; Forster, W.; Kretzinger, B.: Volkscomputer. Utting: Gameplan-Verlag, 2011. Weitere Computer mit SID-Chip waren der Commodore CPM-II, C128 und VC-10. Der SID-Chip prägte somit das Klangerlebnis vieler Spiele dieser Zeit, trug wesentlich zum Erfolg des C64 bei und findet noch heute in einem Subgenre computergestützter Musikerzeugung – den sogenannten Chiptunes – breite Anwendung.[48]vgl. Dittbrenner, N.: Soundchip-Musik: Computer- und Videospielmusik von 1977–1994.Osnabrück: Verlag Universität Osnabrück, 2007, S. 24–28. Klangbeispiele von Chiptunes aus [Dittbrenner … Continue reading Der Chip fungierte als Mini-Synthesizer und war in der Lage, drei unabhängige Stimmkanäle zu erzeugen. Eine systematische Untersuchung weiterer Soundchips von Heimcomputern und Konsolen von 1977 bis 1994 und ihrer technischen Merkmale findet sich in [Dittbrenner 2007].[49]Dittbrenner, N.: Soundchip-Musik: Computer- und Videospielmusik von 1977–1994.Osnabrück: Verlag Universität Osnabrück, 2007. Eine Besonderheit des SID ist seine hybride Bauweise unter der Verwendung von kombinierbaren analogen Filtern (u.a. Tiefpass und Bandpass) während andere Elemente digital angesteuert wurden. Diese analogen Filter waren integraler Bestandteil der Musikerzeugung, lassen sich jedoch mittels Digitaltechnik heutiger volldigitaler Soundkarten nur mit erheblichem Rechenaufwand approximieren. Ein identischer Klang kann in der Regel nicht erreicht werden. Die Berechnungen könnten zudem zu Geschwindigkeitseinbußen des Emulators führen. Für Schallwellen darf jedoch die Echtzeitbedingung nicht verletzt werden. Die Emulationsgeschwindigkeit darf nicht geringer sein als die des Originalsystems, da es sonst zu Verzerrungen der Klangausgabe kommen würde.

Als Lösung werden in Emulatoren sogenannte Samples verwendet, digitalisierte Ausschnitte eines analogen Audiosignals. Es handelt sich also um gespeicherte Tonaufnahmen des Originalchips. Dazu wird die Wiedergabe gewisser Grundfrequenzen unter Anwendung der analogen Filter aufgenommen, über Analog-Digital-Wandler digitalisiert und kann dann im Emulator für die gewünschte Ausgabefrequenz transponiert wiedergegeben werden. Diese Technik wird z.B. im C64-Emulator VICE (siehe Tabelle 1) verwendet.[50]Siehe VICE-Handbuch unter http://www.cs.cmu.edu/~dsladic/vice/doc/html/vice_6.html. Analoge Klangerzeugung wurde ebenfalls vielfältig in frühen Arcade-Automaten eingesetzt, da bestimmte Effekte mit der damaligen Digitaltechnik nicht zu realisieren waren. Die Verwendung von Samples für diese Automaten ist daher ebenfalls integraler Bestandteil des M.A.M.E.-Emulators (siehe Tabelle 1). Trotz digitaler Neuberechnung und der Verwendung von Samples ist es nicht möglich, den analogen Klang der Originalchips vollständig zu reproduzieren.

Ein weiteres Beispiel für komplexe Klangerzeugung ist der Systemlautsprecher (PC-Speaker) früher x86-PCs. Dieser Lautsprecher ist ein Standardbestandteil aller IBM-kompatiblen PCs und stellte bis etwa Anfang der 1990er-Jahre die einzige Möglichkeit dar, auf einem PC Töne zu erzeugen. Abgelöst wurde diese Technik durch das Aufkommen und die breite Verfügbarkeit von dedizierten Soundkarten. Diese bestanden zumeist aus zwei Teilen, einem Analog-Digital- und einem Digital-Analog-Wandler zur Aufnahme bzw. Wiedergabe von 8- und 16-bit-Samples und einem MIDI-konformen Synthesizer mit eingebauten Samples für die entsprechenden Instrumente. Der Systemlautsprecher verfügte hingegen nur über die Zustände „an“ und „aus“, physisch repräsentiert durch die verschiedenen Extrema der Membran des Lautsprechers. Prinzipiell können also nur angenäherte Rechteck-Schwingungen erzeugt werden. Entgegen dieser Spezifikation fanden Programmierer eine Möglichkeit mittels komplexer Timingsteuerung über die Systemuhr des PCs digitalisierte 6-bit-Klänge über den Systemlautsprecher abzuspielen und andere Wellenformen zu erzeugen. Dazu wurde der Lautsprecher bzw. dessen Membran über Interrupts schneller angesteuert, als sie sich physisch bewegen konnte. Diese Technik wurde von mehreren Spielen dieser Zeit aufgegriffen, um Musik und digitalisierte Sprache ohne die Verwendung von Soundkarten abzuspielen.[51]Für eine detaillierte Beschreibung sowie Klangbeispiele siehe http://www.oldskool.org/sound/pc/#digitized.

Eine Emulation dieses Verhaltens ist auf die korrekte Nachahmung der PC-Uhr und komplexer Timing-Strukturen angewiesen. Der Emulator DOS-Box (siehe Tabelle 1) ist beispielsweise in der Lage, diese Klänge wiederzugeben. Dabei ist jedoch zu beachten, dass moderne Soundkarten und angeschlossene Lautsprecher nicht die Beschränkungen des Systemlautsprechers aufweisen. Eine Wiedergabe im Emulator führt daher zu einem deutlich besseren Klangbild mit weniger Verzerrungen, als dies über den damaligen Systemlautsprecher physisch möglich war.

Diese ausgewählten Beispiele verdeutlichen die Grenzen der Reproduktion analoger Klangerzeugungssysteme und spezifischer Hardwareeigenheiten. Samples sind in der Lage, diese Abweichungen zu verringern. Das Klangbild in der emulierten Umgebung entspricht in den oben genannten Fällen jedoch nicht dem der Originalumgebung. Die konzeptuelle Ebene des Objektes wird also verändert.

4.2.3 Eingabegeräte

Um Nutzereingaben entgegenzunehmen, wurden insbesondere im Spielebereich eine Vielzahl von Eingabegeräten entwickelt. Diese reichen von aus dem Arcade- und Konsolenbereich bekannten Joysticks und Joypads bis hin zu Spezialanfertigungen für ein bestimmtes bzw. eine bestimmte Klasse von Spielen wie Mikroschalter-gesteuerte Snowboards, druckempfindliche Tanzmatten, Laserpistolen, Karaoke-Mikrofone, Tasten-„Gitarren“, VR-Helme (Virtual Reality) und Gestensteuerung über 3D-Kameras. Die Interaktionsmöglichkeiten sind dabei vielfältig und immer auf das Spiel und dessen Ereignisverlauf zugeschnitten. Zwar bleiben grundlegende physische Interaktionsmöglichkeiten zwischen Mensch und Rechner relativ stabil, da sie an die Funktionsweise der Sinnesorgane des Menschen gekoppelt sind, welche im Prinzip ebenfalls stabil sind. Dennoch lassen sich die konkreten Ausprägungen künftiger Interaktionskonzepte in Hardware kaum vorhersagen.

Mobile Plattformen, wie die Apple iOS-Geräte iPad, iPhone und iPod touch, besitzen 3-Achsen-Beschleunigungssensoren und einen Gyrokompass mit dessen Hilfe Spiele für diese Systeme die Lage, Bewegung und Orientierung des Gerätes im Raum feststellen können. Eine weitere Kategorie bilden spezielle Controller, die durch Aktoren wie Elektromotoren physische Rückmeldung (ein sogenanntes „Force-Feedback“) an den Spieler ermöglichen und damit gleichzeitig Ausgabegerät sind.[52]vgl. Guttenbrunner, M.; et al.: Keeping the Game Alive: Evaluating Strategies for the Preservation of Console Video Games. In: International Journal of Digital Curation, Volume 1, Issue 5, … Continue reading In jüngster Zeit ist ein Trend zu 3D-Fernsehern und -Bildschirmen sowie zu kombinierten VR-Systemen wie beispielsweise Oculus Rift zu beobachten.[53]Siehe Produktwebsite von Oculus VR unter http://www.oculusvr.com/.

Aufgrund dieser so unterschiedlichen Eingabemöglichkeiten, ist eine generelle Kategorisierung der Eigenschaften nicht sinnvoll. Es muss vielmehr das Eingabegerät im Zusammenhang mit der Spielinteraktion betrachtet werden, um signifikante Eigenschaften festzuhalten. Diese können sich allerdings an allgemeinem physischen Beschreibungsmerkmalen wie z.B. der Anzahl der möglichen Freiheitsgrade, der Erfassung von Position, Orientierung, Kraft oder Drehmoment orientieren.

Für die Kommunikation mit dem Rechnersystem findet eine Abstraktion statt. Die physischen Eingabegeräte werden rechnerintern durch logische Eingabegeräte abstrahiert, die über Programmierschnittstellen (API) zur Verfügung gestellt werden. Die Software des dynamischen Objekts kommuniziert nur mit dieser API und damit mit dem logischen Gerät. Ein Emulator kann die API und Hardwareschnittstelle dieses logischen Geräts nur auf logische Geräte des Hostsystems transferieren. Diese abstrahieren ihrerseits an das Hostsystem angeschlossene physische Geräte.

Die Hardwareschwelle kann in Software natürlich nicht überbrückt werden. Ein Software-Emulator ist somit nicht in der Lage, die prinzipiellen Hardwareeigenschaften der Eingabegeräte des Originalsystems nachzuahmen.

Die Erhaltung der signifikanten physischen Eigenschaften ist jedoch essenziell, da es sonst zu einem veränderten Spielerlebnis und damit zu einer abweichenden konzeptuellen Reproduktion kommen kann. Abweichungen können u. a. durch ein verändertes haptisches Feedback entstehen. So waren beispielsweise diverse populäre Sportspiele (wie California Games oder die Olympischen Simulationen Winter Games bzw. Summer Games) für den C64 auf die Benutzung mit Mikroschalter-gesteuerten Joysticks ausgelegt. Die Spielfigur bewegte sich dabei nur durch eine schnelle mechanische abwechselnde Seitenbewegung des Joysticks bis zum Einrasten des Mikroschalters vorwärts. Dadurch sollte bei diesen sogenannten Joystick-„Rüttelspielen“ durch den physischen Aufwand der Bewegung, die „Anstrengung“ der Spielfigur simuliert werden. Für diese Spiele existieren Emulatoren für iOS-Geräte wie das iPad. Da dieses jedoch ohne physische Knöpfe, sondern nur durch Berührung mit den Fingerkuppen (Touch-Bedienung) und Lagesensoren gesteuert werden kann, ist dieser Aspekt der Interaktion mit dem dynamischen Objekt nicht adäquat abbildbar. Die Touch-Bedienung erlaubt wesentlich schnellere Antwortzeiten, als es mit einem Joystick möglich gewesen wäre. Das haptische Erlebnis geht aber vollständig verloren.

Die einzige Möglichkeit, die signifikanten physischen Merkmale dieser Eingabeschnittstellen zu erhalten, liegt in deren Nachbau oder – falls möglich – im Anschluss der Originalgeräte an das Hostsystem und damit außerhalb des Einflussbereichs des Software-Emulators. So existieren Bemühungen alte Eingabegeräte durch ähnliche Hardwarenachbauten, die mit aktuellen Hostsystemen zusammenarbeiten, nachzuahmen.

Beispiele hierfür sind das iControlPad der Firma iControlPad Ltd. oder der JOYSTICK-IT Arcade Stick der Firma ThinkGeek sowie der Fling-Aufsatz der Firma Ten One Design für das iPad.[54]Siehe Produktwebseiten unter http://www.icontrolpad.com, http://www.thinkgeek.com/product/e75a/ sowie http://tenonedesign.com/fling.php. Beim iControlPad handelt es sich um einen Bluetooth-Controller in Form eines Joypads. JOYSTICK-IT und Fling sind Saugnapfaufsätze für den Touchscreen des iPads, die dem Nutzer einen Joystick bzw. ein Joypad zur Steuerung des iPads zur Verfügung stellen. Die iPad-Joysticks sind in Abbildung 4.4 dargestellt. Die Abhängigkeit von physischen Geräten stellt somit eine weitere prinzipbedingte Grenze von Software-Emulatoren dar.

Abb 4.4: Produktfotos des JOYSTICK-IT (links) und Fling-Aufsatzes (rechts)[55]Quelle: ThinkGeek.com: JOYSTICK-IT Arcade Stick for iPhone. Produktwebsite. [abgerufen 20.10.2012] und Tenonedesign.com: fling – Analog Joystick for iPad. Produktwebsite., Bild-URLs: … Continue reading

4.2.4 Diskussion der Translationsprobleme

Die Translation von Ein-/Ausgabeschnittstellen auf die Hardware des Hostsystems bedingt eine Veränderung der Rezeptionsumgebung. Allen Abweichungen gemein ist die damit einhergehende Veränderung der Interaktion mit der Rezeptionsumgebung und dem dynamischen Objekt auf konzeptueller Ebene. Besonders für komplexe dynamische Objekte wie Computerspiele kann dies Auswirkungen unterschiedlichen Grads auf das Spielerlebnis und die Immersion in das Spielgeschehen haben, da Immersion und Rezeptionsumgebung in enger Verbindung stehen. Wie im Bereich der Computerkunst müssen Aspekte der Aufführungspraxis berücksichtigt werden, sofern sie signifikant zum Spielerlebnis beitragen. Das Bestreben der Erhaltung bzw. Nachbildung der physischen Merkmale der Rezeptionsumgebung ist auch bei anderen Medien zu finden und besitzt eine Tradition als konservatorisches Mittel. So gibt es beim Fernsehsender ZDF.kultur den Programmbereich „ZDF.kult“, in der beliebte Fernsehsendungen der 1970er- und 1980er-Jahre (wie Dalli Dalli) wiederholt werden. Der Sender veränderte die Ausstrahlung dieser Sendungen mit Digitalfiltern, welche das Bild verzerren und wölben, und fügte des Weiteren einen schwarzen Rahmen ein. Damit sollte die ursprüngliche Rezeption mittels Röhrenfernsehern auf heute gängigen Flachbildfernsehern simuliert werden, um der historischen Aufführungspraxis dieser Sendungen näher zu kommen. Zentral ist für den Sender die Wahrnehmung durch den Zuschauer.[57]vgl. Huber, J.: Simulanten-Fernsehen. Aus dem Archiv ins Museum. In: Der Tagesspiegel, Artikel vom 15.5.2011, Online-Ausgabe, 2011.

Im Fall von Arcade-Spielen, welche auf in Spielhallen aufgestellten Automaten rezipiert wurden, können auch Umgebungsgeräusche zu den signifikanten Eigenschaften der Rezeptionsumgebung gehören, wie vom Bewahrungsprojekt Arcade Ambience Sound Project verdeutlicht.[58]vgl. Hofle, A.: Arcade Ambience Project Intro. Website, 2009.

In den vorangegangen Abschnitten wurden für die Ein- und Ausgabeschnittstellen von Rechnersystemen Beispiellösungen in Hard- und Software vorgestellt, welche in der Lage sind, das Problem der Translation Gap abzumildern. Im Bereich der Bild- und Tonausgabe werden dafür zumeist Digitalfilter in der Emulationssoftware eingesetzt, um signifikante Eigenschaften des Originalsystems nachzuahmen. Die dazu notwendigen Berechnungen sind jedoch komplex und erhöhen die Rechenlast auf dem Hostsystem. Für die physischen Eigenschaften von Eingabegeräten gibt es keine solche Entsprechung in Software. Zur Erhöhung der Authentizität werden hier Hardware-Nachbauten[59]Für Arcade-Spiele existieren im Internet – getrieben durch die Retro-Computing Community – diverse Anleitungen zum Nachbau der entsprechenden Arcade-Automaten in Verbindung mit … Continue reading oder Konverter zum Anschluss der Originalperipherie eingesetzt.

Technisch handelt es sich bei beiden Strategien um Skeuomorphismen (von griech. skeuos für „Utensilien“ und morphê für „Form“), materielle Metaphern, die funktional bzw. strukturell inhärente Eigenschaften von zur Funktion notwendigen und intrinsischen Komponenten des Originalsystems in der Emulationsumgebung nachbilden. Dabei verlieren diese ihren originären Zweck und nehmen einen schmückenden Charakter an. Ziel ist immer die Minimierung von Abweichungen in der Wahrnehmung von Original- und Zielsystem bzw. Objekt.[60]vgl. Gessler, N.: Skeuomorphs and cultural algorithms. In: Porto, V. W.; et al. (Hrsg.): Evolutionary Programming VII, Proceedings of the 7th International Conference (EP98), San Diego, CA, … Continue reading

Sowohl bei Hard- als auch Softwarelösungen bilden ein Spannungsfeld zwischen Komplexität und technischer sowie ökonomischer Machbarkeit. Hier müssen pragmatische Fallentscheidungen getroffen werden. Wo eine Erhaltung bzw. Nachahmung ökonomisch nicht umsetzbar oder sinnvoll ist, können technische Abweichungen in den Metadaten festgehalten werden. Auch hier wurden Kriterien und Beispiellösungen vorgestellt.[61]Für eine systematische Aufarbeitung des Translationsproblems unter pragmatischen und technischen Gesichtspunkten anhand einer Fallstudie am komplexen Virtual-Reality-3D-System Cybermind sei auf … Continue reading

Das Translationsproblem ist jedoch eine systemimmanente Komponente der Emulationslösung. Je weiter sich die Schnittstellen bzw. Hardware des Hostsystems in ihren intrinsischen Eigenschaften von denen des Originalsystems unterscheiden, desto größer werden Abweichungen und eventuelle Verluste der Reproduktion. Skeuomorphismen können diese nur bis zu einem gewissen Grad abmildern. Eine Langzeitprognose zur Erhaltung des Kontexts erscheint schwierig, da künftige Interaktionskonzepte und ihre technischen Ausprägungen in Hardware schwer vorherzusagen sind. Auch konnte gezeigt werden, dass bisher keine generische Verfahrensweise zur Identifikation signifikanter Eigenschaften und deren technischer Umsetzung existiert. Vielmehr haben sich Best-Practice-Lösungen anhand von Fallstudien etabliert.

Da Skeuomorphismen im Emulator implementiert sind, werden Abwägungen und Entscheidungen zur Minimierung der Translation Gap faktisch bereits bei Erstellung des Emulatorprogramms getroffen und sind bedingt durch die technische Komplexität eines Software-Emulators nur unter hohem Aufwand reversibel. Guttenbrunner und Rauber sehen die Anpassung der Daten-Ein- und Ausgabemethoden auf die Gegebenheiten künftiger Systeme als eine zentrale Designentscheidung bei der Entwicklung von Emulatoren.[62]vgl. Guttenbrunner, M.; Rauber, A.: Design Decisions in Emulator Construction: A Case Study on Home Computer Software Preservation. In: Proceedings of the 8th International Conference on … Continue reading Es ist daher wichtig, Bezugsquellen und Entwicklergruppen von Emulatoren näher zu untersuchen, um Entscheidungskompetenzen und Motivationen aufschlüsseln zu können. Dies soll in den folgenden Abschnitten geschehen.

Implizit hat sich durch die Translationsproblematik eine neue (verdeckte) Anforderung an Software-Emulatoren herauskristallisiert. Der Emulator muss zur Erzeugung von Skeuomorphismen weitere Funktionen bzw. Funktionalitäten übernehmen, die programmatisch nicht Teil des Originalsystems waren. Nur so kann eine Annäherung an eine originalgetreue Wiedergabe der dynamischen Objekte erreicht werden. Die technische Umsetzung z. B. komplexer digitaler Filter stellt vielmehr eine Zusatzanforderung an die Software dar und bildet für Emulatoren im Kontext der Langzeitarchivierung einen neuen Teilaspekt, der bei der Auswahl bzw. Implementierung von Emulatoren zu berücksichtigen ist.

Dies findet in der Literatur zum Thema jedoch zur Zeit noch keine Beachtung.[63]So findet beispielsweise im „Preserving Virtual Worlds“-Abschlussbericht in McDonough, J.; et al.: Preserving Virtual Worlds – Final Report. 2010 keine technische Ausdifferenzierung der … Continue reading Diese Problematik sowie weitere im Folgenden diskutierte Faktoren führen jedoch dazu, dass es nach wie vor Architekturen bzw. Systeme gibt, für die kein Emulator existiert.

4.3 Entwicklergruppen und Bezugsquellen für Emulatoren

Die Archivierung und Bewahrung von born-digital-Material und komplexen digitalen Objekten ist für Bibliotheken, Archive und anderen Gedächtnisorganisationen immer noch ein großes Problem, da keine durchgängige technologische Methodologie existiert.[64]vgl. Cohen, P.: Fending Off Decay, Bit by Bit. In: New York Times, New York Edition, Jg. 2010, 16.3.2010, Section C1. Soll zur Bewahrung des Archivs Emulation eingesetzt werden, so sind diese Organisationen auf externe Computerspezialisten und Entwickler angewiesen, da in der Regel weder die personellen oder finanziellen Ressourcen noch die technische Kompetenz zur Entwicklung eines Emulators im Haus vorhanden ist.[65]vgl. ebenda. Selbst in internationalen Forschungsprojekten zu diesem Thema ist es größtenteils nicht möglich, eigene Emulatoren zu entwickeln. Stattdessen werden bestehende Emulationsprogramme evaluiert und verwendet (siehe Abschnitt 3.2). Die Menge der erhaltbaren Objekte, die Genauigkeit der Erhaltung und dadurch der Bewahrungserfolg hängen somit maßgeblich von einer extern erstellten Komponente ab (siehe Abschnitt 3.8) und liegen nur bedingt im Einflussbereich der kulturbewahrenden Institution.

Huth erkennt hier eine effektive Kompetenzverschiebung. Der Emulator wird zum Arbeitsmittel der digitalen Bibliothek, der Bibliothekar hat jedoch nicht die nötigen Fachkenntnisse, diesen zu erstellen. Der Ersteller des Emulators entscheidet damit faktisch über das erhaltbare Archivgut und trifft die technischen Entscheidungen, welche – einmal in Software gegossen – schwer wieder umkehrbar sind.[66]vgl. Huth, K.: Probleme und Lösungsansätze zur Archivierung von Computerprogrammen – am Beispiel der Software des ATARI VCS 2600 und des C64. Diplomarbeit, HU Berlin, 2004, S. 73. Es ist deshalb wichtig, die Bezugsquellen von Emulatoren und die Beweggründe bzw. Ziele der Programmierer zu kennen.

In [van der Hoeven und van Wijngaarden 2005][67]van der Hoeven, J.; van Wijngaarden, H.: Modular emulation as a long-term preservation strategy for digital objects. In: Proceedings of the 5th International Web Archiving Workshop (IWAW05), im … Continue reading werden Beweggründe hinter der Entwicklung verfügbarer Emulatoren analysiert. Die Autoren bestimmen dabei die Entwicklung zur Emulation von game computer platforms und aus nostalgischem Interesse an der Funktionsweise alter Computer (historic computing) durch Hobbyprogrammierer als einen Grund. Eine weitere Kategorie bildet die kommerzielle Entwicklung durch Firmen für Zwecke der business efficiency, üblicherweise im Bereich der Virtualisierung, Ressou centeilung oder für Applikationstests.[68]vgl. ebenda, S. 6].

Auch bilden Forschung und Wissenschaft eine weitere Gruppe von Akteuren. Mit Dioscuri (siehe Abschnitt 3.2.1) wurde ein erster Emulator speziell für die Anforderungen der digitalen Langzeitarchivierung entwickelt. In der Tat lassen sich drei Kategorien von Entwicklerkreisen identifizieren: Nostalgisch getriebene, kostenlose Emulatoren einer Hobby-Community; kommerzielle Emulatoren der Wirtschaft vorwiegend zur Virtualisierung von Betriebssystemen; schließlich Emulatoren aus Forschung und Wissenschaft zum Zwecke der Langzeitbewahrung.

Die einzelnen Akteure sollen im Folgenden näher beleuchtet werden, um eine Gegenüberstellung der jeweiligen Entwicklungsziele der Gruppen zu den Anforderungen im Rahmen der Langzeitbewahrung zu ermöglichen. Zunächst soll dazu die Gewichtung der Gruppen anhand der Auswahl von in aktuellen Projekten verwendeten Emulatoren ermittelt werden.

4.3.1 Auswahlkriterien für Emulatoren in aktuellen Projekten

Es stellt sich die Frage, nach welchen Kriterien Emulatoren für Langzeitbewahrungsprojekte ausgewählt werden. Wie bereits beobachtet, kommen bei derzeitigen Forschungsprojekten und Bewahrungsinitiativen (siehe Abschnitt 4.3) fast ausschließlich bereits existierende Emulatorprogramme zum Einsatz. Bewahrungsprojekte sind damit direkt auf die Erstellung und Pflege durch Dritte angewiesen. Dementsprechend orientieren sich Auswahlkriterien an technischen Kriterien wie modularen und nach modernen Software-Engineering-Methoden entwickelten Programme sowie an organisatorischen und lizenzrechtlichen Eigenschaften wie der Bereitstellung als Open-Source unter einer gängigen freien Lizenz, um einer größtmöglichen Zahl von Programmierern aus den entsprechenden Communities den Zugriff und die Weiterentwicklung des Emulators zu ermöglichen und diese zu fördern. In [von Suchodoletz 2009][69]von Suchodoletz, D.: Funktionale Langzeitarchivierung digitaler Objekte. Dissertation, Freiburg: Albert-Ludwigs-Universität Freiburg, 2009. werden Kriterien anhand von Nutzungsszenarien identifiziert. Von Suchodoletz nennt die „Vollständigkeit“ der Nachbildung des Originalsystems durch den Emulator, die Anforderungen an das zur Verfügung stehende Hostsystem, Datenim- und -exportmöglichkeiten des Emulators sowie Zusatzfunktionen bei der Benutzerinteraktion (siehe Abschnitt 3.3) als wichtige technische Leitlinien.[70]vgl. ebenda, S. 77. Hinzu kommen ökonomische Abwägungen bei der Wahl zwischen kommerziellen und Open-Source-Emulatoren. Die initiale Auswahl kann dann anhand von vier Kenngrößen – Kosten, Langzeitverfügbarkeit, Nutzerkreis, Archivgröße – weiter eingeschränkt werden. Von Suchodoletz nennt zudem Tauglichkeit, Nutzbarkeit, Zuverlässigkeit, Performance, Portabilität, verwendete Programmiersprache, Relevanz und Marktdurchdringung als weitere sachlich-pragmatische Anforderungen an den Emulator.[71]vgl. ebenda, S. 98.

Die Autoren des Abschlussberichtes des auf die Bewahrung von komplexer interaktiver Objekte ausgelegten „Preserving Virtual Worlds“-Projektes stellen einen ähnlichen Kriterienkatalog auf. Der Emulator soll darin ebenfalls auf frei verfügbarem Quelltext mit einer entsprechenden Lizenz basieren und zudem aktiv gepflegt und weiterentwickelt werden. Das Programm muss zudem eine Reihe von aktuellen Hostbetriebssystemen unterstützen und portabel sein. Des Weiteren muss ausreichend interne und externe Dokumentation für das Projekt vorhanden und der Emulator auch von Nicht-Technikern leicht zu bedienen sein. Ebenfalls genannt wird die Wichtigkeit einer vergleichbaren Genauigkeit der Spielerfahrung zum Originalsystem sowie der originalgetreuen Nachahmung einer Vielzahl von Peripheriegeräten.[72]vgl. McDonough, J.; et al.: Preserving Virtual Worlds – Final Report. 2010, S. 64.

Wiederkehrende zentrale Forderungen sind also die Vollständigkeit bzw. Genauigkeit der Emulation, die Fehlerfreiheit und Entwicklung des Emulators nach modernen technischen Standards sowie eine Bevorzugung von quelloffenen und kostenfreien Emulatoren.

Um diese Anforderungen den Motivationen der jeweiligen Entwicklergruppen gegenüber stellen zu können, ist es sinnvoll, zunächst diejenige mit dem größten Anteil an derzeit verwendeten Emulatoren zu identifizieren. Anschließend sollen die Ziele der einzelnen Akteure genauer untersucht und gegenübergestellt werden.

4.3.2 Untersuchung von Emulatoren nach Entwicklergruppe

Zur Ermittlung der Gruppenanteile wurden die in Abschnitt 3.7.1 aus der Literatur identifizierte Stichprobe von Emulatoren im Hinblick auf Autorgruppe (Community, kommerzieller Hersteller, Forschung und Wissenschaft), Quelloffenheit bzw. verwendete Lizenz und damit eventuell verbundener Kosten sowie auf den Wartungsstatus der Software bzw. die Aktivität des Projektes kontrolliert. Die Ergebnisse sind tabellarisch in Tabelle 2 zusammengefasst.

Tabelle 2: Auflistung untersuchter Emulatoren nach Lizenz und Status

| Name (Vertreter) | Gruppe | Architektur | Lizenz | Aktiv?, (seit) | letzte Version vom (Datum) |

|---|---|---|---|---|---|

| SIMH | Community | frühe Großrechner | modifizierte X-Windows Lizenz | ja, (1993) | 2012-05-03 |

| Hercules | Community | frühe Großrechner | Q Public Licence | ja, (1999) | 2010-03-10 |

| M.A.M.E. | Community | Arcade-Systeme | MAME Lizenz

non-profit |

ja, (1997) | 2012-09-17 |

| ARAnyM | Community | Heimcomputer | GPL v2 | ja, (2002) | 2012-10-04 |

| Arnold | Community | Heimcomputer | GPL | nein, (2001) | 2004-01-11 |

| Hatari/WinSTon | Community | Heimcomputer | GPL | ja, (2001) | 2012-06-24 |

| JaC64 | Community | Heimcomputer | GPL | nein, (2006) | 2007-12-31 |

| VICE | Community | Heimcomputer | GPL | ja | 2011-02-26 |

| M.E.S.S. | Community | Heimcomputer | MAME Lizenz

non-profit |

ja, (1998) | 2012-02-07 |

| UAE | Community | Heimcomputer | GPL | ja, (1995) | 2012-05-09 |

| DOSBox | Community | PC / Mac / x86 | GPL v2 | ja, (2002) | 2010-05-12 |

| Dioscuri | Forschung | PC / Mac / x86 | GPL v2 | ja, (2006) | 2011-01-19 |

| JPC | Community | PC / Mac / x86 | GPL v2 | ja, (2007) | 2010-05-24 |

| Parallels Workstation | kommerziell | PC / Mac / x86 | kommerziell | ja | 2011-11-08 |

| Plex86 | Community | PC / Mac / x86 | GPL | nein | 2003-12-19 |

| QEMU | Community | PC / Mac / x86 | GPL v2 | ja | 2012-09-05 |

| VirtualPC | kommerziell | PC / Mac / x86 | kommerziell | nein | 2011-02-10 |

| VirtualBox | Community | PC / Mac / x86 | GPL v2 | ja | 2012-09-13 |

| VMWare | kommerziell | PC / Mac / x86 | kommerziell | ja | 2012-09-10 |

| PearPC | Community | PC / Mac / x86 | GPL | ja | 2011-07-13 |

| Mini vMac | Community | PC / Mac / x86 | GPL v2 | ja | 2012-08-06 |

| Basilisk II | Community | PC / Mac / x86 | GPL | nein | 2001-05-31 |

| PCSX | Community | Spielekonsolen | GPL | nein, (2000) | 2003-05-12 |

| SNES9x | Community | Spielekonsolen | nicht-kommerziell | ja, (1997) | 2011-04-25 |

| vNES | Community | Spielekonsolen | GPL | nein, (2008) | 2011-06-09 |

| ZSNES | Community | Spielekonsolen | GPL v2 | ja, (1997) | 2007-01-24 |

| Gens32 | Community | Spielekonsolen | Gens: GPL

Gens32: Closed Source |

ja, (2005) | 2009-12-23 |

| Kega Fusion | Community | Spielekonsolen | nicht-kommerziell

Closed Source |

ja | 2010-03-07 |

| NeoCD | Community | Spielekonsolen | nicht-kommerziell | nein | 2005 |

| Nebula | Community | Spielekonsolen | nicht-kommerziell

Closed Source |

nein | 2007-02-18 |

| O2EM | Community | Spielekonsolen | Artistic Licence | nein | k. A. |

| Dega | Community | Spielekonsolen | nicht-kommerziell | nein | 2004-04-14 |

| PCSX2 | Community | Spielekonsolen | GPL | ja | 2012-08-01 |

| Stella | Community | Spielekonsolen | GPL v2 | ja | 2012-06-10 |

| 1964 | Community | Spielekonsolen | GPL | ja | 2012-06-01 |

| Dolphin | Community | Spielekonsolen | GPL v2 | ja | 2011-12-24 |

| nullDC | Community | Spielekonsolen | GPL v3 | nein | 2011-08-21 |

| Yabause | Community | Spielekonsolen | GPL | ja | 2011-11-27 |

| cxbx | Community | Spielekonsolen | GPL | nein | 2004-09-06 |

| GNUBoy | Community | Mobile Geräte | GPL | nein | 2001-12-08 |

| DeSmuME | Community | Mobile Geräte | GPL | ja | 2012-04-09 |

Tabelle 2: Auflistung untersuchter Emulatoren nach Lizenz und Status

Die Angaben zur Lizenz, dem Erscheinungsjahr der ersten und zum Datum der aktuellen Version, der 41 gelisteten Emulatoren, wurden – soweit verfügbar – direkt von der Projektseite, bzw. der Seite des Herstellers übernommen. Stand der Daten ist der 5. Oktober 2012. Der größte Anteil (37 von 41, entspricht 90 Prozent) der diskutierten Emulatoren wurde dabei von Hobbyprogrammierern aus der Emulatorencommunity entwickelt. Drei Emulatoren stammen von kommerziellen Herstellern. Bei ihnen handelt es sich ausnahmslos um Virtualisierer. Lediglich ein Emulator (Dioscuri) stammt aus dem Bereich Wissenschaft und Forschung. Bis auf drei Ausnahmen ist der Quelltext der 37 Community-Emulatoren frei verfügbar. Etwa zwei Drittel (24 von 37, entspricht 65%) dieser Emulatoren stehen unter einer Version der GNU General Public Licence (GPL), einer Lizenz der Free-Software-Foundation, mit dem Ziel, die Software und alle daraus entstandenen Derivate dauerhaft nicht kommerziell und quelloffen zu vertreiben.[73]Siehe Lizenzvereinbarung auf der Projektseite unter http://www.gnu.org/licenses/gpl.html. Ob ein Projekt noch aktiv gepflegt wird, lässt sich bei Community-Projekten nicht unbedingt aus dem Erscheinungsdatum der letzten Version ableiten. Da die Emulatoren als Hobby in der Freizeit entwickelt werden, können zwischen zwei Version oft lange Zeitabstände liegen. Auch ändern sich die Rechtsverhältnisse oft, wenn eine andere Entwicklergruppe die Arbeit eines oft kleinen Teams oder einer Einzelperson übernimmt (sogenannte Maintainer). Auch ermöglicht die Quelloffenheit die Abspaltung in Teilprojekte (sogenannte Forks). Diese Seitenstränge mit getrennter Funktionserweiterung, wie beispielsweise beim vNES-Emulator machen es schwer, die „beste“ Version zu ermitteln. Zum Status des Projekts wurde daher immer den zusätzlichen Angaben auf der Projektseite vertraut. Etwa die Hälfte der gelisteten Emulatorprojekte ist noch aktiv.

Die Anzahl vertretener kostenloser Open-Source-Emulatoren – häufige Merkmale von Community-Emulatoren – korreliert mit den Anforderungen der Kriterienkataloge. Eine Community von Hobbyprogrammierern bildet somit den „Hauptlieferanten“ der Emulatoren für viele Langzeitbewahrungsprojekte dynamischer Objekte. Es ist daher wichtig, insbesondere die Motivation und Zielsetzung dieser Gruppe zur Entwicklung von Emulatoren zu verstehen und Verbindungen zwischen den Akteuren aufzubauen, wie es das KEEP-Projekt versucht hat (siehe Abschnitt 3.2.3).

4.3.3 Open-Source und „Community“-Emulatoren

Wie gezeigt, wird der größte Anteil verwendeter Emulatoren von einer am Thema „retro-computing“ interessierten Gemeinde von technisch versierten Hobbyisten entwickelt. Für diese Gruppe dienen Emulatoren dazu, obsolete Video- und Computerspiel-Plattformen auf modernen Computersystemen wieder erlebbar zu machen.[74]vgl. Rothenberg, J.: Using Emulation to Preserve Digital Documents. Den Haag: Koninklijke Bibliotheek (RAND-Europe), 2000, S. 27. Dabei stehen der nostalgische Aspekt und das Interesse an alten Computerplattformen im Vordergrund. Insbesondere mit den Computerspielen der Kindheit und Jugend werden meist intensive und positive Erlebnisse verbunden, woraus ein Bedürfnis entwächst, diese Erinnerungen wieder aufleben zu lassen. Das Hauptaugenmerk bei der Emulatorentwicklung richtet sich daher darauf, diese (zumeist populären) Spiele möglichst authentisch wiedergeben zu können. So soll das „Gefühl“ und die Immersion des damaligen Spielerlebnisses in die heutige Zeit transformiert werden. Rothenberg sieht darin einen erwünschten Nebeneffekt für die Genauigkeit der programmierten Emulatoren, “[…] because computer games are notorious for placing heavy demands on their supporting hardware and on being highly dependent on the idiosyncrasies of this hardware, including interface devices, displays, execution and interaction timing, etc.”.[75] ebenda, S. 29.

Das aus der Motivation entstehende Entwicklungsziel begünstigt Emulatoren mit hoher technischer Genauigkeit und einem Fokus auf authentischer Reproduktion der Rezeptionsumgebung. Dabei wird versucht, möglichst jedes audiovisuelle Detail der damaligen Interaktion nachzuahmen. Dies schließt nicht nur das digitale Artefakt selbst mit ein, sondern kann insbesondere auch die Eigenarten der Hardwareplattform und der Rezeptionsumgebung selbst erfassen (siehe auch Abschnitt 4.2). So kann z.B. der Amiga-Emulator UAE das Ladegeräusch des Amiga-Diskettenlaufwerks beim Betrieb nachbilden. Die charakteristischen Geräusche blieben vielen Spielern beim Warten auf den Beginn des Spiels und beim Nachladen von Spielsequenzen im Gedächtnis und trugen nach Meinung der UAE-Entwickler zur Spielerfahrung bei.

Im Zentrum der Bewahrungsinitiativen stehen somit populäre Spiele und Systemarchitekturen, die Teil eines „kollektiven Gedächtnisses“ sind. Programme und Systeme mit geringer Verbreitung oder andere Einsatzzwecke (z.B. Software aus dem Geschäftsalltag) werden nicht explizit getestet bzw. bei der Emulatorentwicklung berücksichtigt. Dies hat Auswirkungen auf die Menge der erhaltbaren Objekte und widerspricht dem umfassenden Sammlungs- und Bewahrungsziel von Gedächtnisorganisationen.

Conley et al.[76]Conley, J.; Andros, E.; Chinai, P.; Lipkowitz, E.; Perez, D.: Use of a Game Over: Emulation and the Video Game Industry: A White Paper. In: Northwestern Journal of Technology and Intellectual … Continue reading beschreiben den Auswahlprozess und Faktoren für die Wahrscheinlichkeit der Erstellung eines Emulators durch die Community. Obwohl Emulatoren für eine Vielzahl von Systemen zur Verfügung stehen, existieren insbesondere für seltene und technisch anspruchsvolle Systeme keine Emulatoren. Die Autoren nennen drei Einflussfaktoren. Ein Faktor ist die Popularität des Systems (console popularity), welche in direktem Zusammenhang zur Nachfrage nach einem Emulator steht. Ein weiterer ist die Verfügbarkeit detaillierter technischer Informationen über die Hard- und Software des Systems, welche zur Implementierung des Emulators benötigt wird. Letztlich spielt ebenso die Komplexität und der Schwierigkeitsgrad der Emulatorentwicklung für das jeweilige System eine Rolle.[77]vgl. ebenda, S. 264.

Dies konnte vom Autor dieser Arbeit in einem begleitenden Forschungsseminar mit dem Computerspielemuseum Berlin zum Thema Softwarearchäologie anhand einer Fallstudie zur Restaurierung des 3D-Spielesystems Cybermind SU 2000 (1994) empirisch nachvollzogen werden. Für dieses System existiert aufgrund der geringen Verbreitung, der fehlenden Dokumentation, der speziellen Hardwarechips sowie der Schwierigkeiten bei der Nachbildung der komplexen 3D-Sensoren und -Aktoren kein Emulator. Nachfragen an die Community und der Versuch einer Zusammenarbeit blieben im Rahmen des Seminars ebenso erfolglos. Die Ergebnisse sind in [Loebel 2011b] veröffentlicht.[78]Loebel, J.-M.: Erhaltung virtueller Realitäten. Restauration eines Virtual-Reality-Simulators für das Computerspielemuseum Berlin – ein Projektbericht. In: Sieck, J. (Hrsg.): Kultur und … Continue reading

Bei populären Systemen, für die vom Hersteller keine technische Dokumentation veröffentlicht wurde oder diese durch Patente geschützt ist, werden stattdessen Methoden des Reverse-Engineerings angewandt, um Emulatoren zu schreiben. Es kann daher nur beobachtbares Verhalten des Systems nachgeahmt werden, wobei nur Vermutungen über die interne Implementierung bestimmter Chips angestellt werden können. Dadurch kann ein unvorhersagbares Wechselspiel der Systemkomponenten entstehen, das Abweichungen auf der konzeptuellen Ebene des Objekts begünstigt.

Diese Nachkonstruktion anhand des beobachtbaren Systemverhaltens hat zudem direkten Einfluss auf die Entwicklungszeit, den Schwierigkeitsgrad und die erreichbare Vollständigkeit der Implementierung.[79]vgl. Conley, J.; Andros, E.; Chinai, P.; Lipkowitz, E.; Perez, D.: Use of a Game Over: Emulation and the Video Game Industry: A White Paper. In: Northwestern Journal of Technology and Intellectual … Continue reading Die Autoren sehen insbesondere in den Anti-Piraterie-Funktionen neuerer Konsolensysteme eine deutliche Hürde bei der Erstellung von Emulatoren für diese Systeme.[80]vgl. ebenda. Ebenso werden eventuell nicht alle Funktionen bzw. Schnittstellen des Originalsystems emuliert, wenn diese Funktionen nicht von Spielen genutzt wurden. Dazu zählen u.a. proprietäre Erweiterungsports und häufig serielle und parallele Schnittstellen des Systems.